Apa itu LightGBM

LightGBM, singkatan dari Light Gradient Boosting Machine, adalah perpustakaan gradient boosting cepat, terdistribusi, dan berkinerja tinggi yang dikembangkan oleh Microsoft. Ini dirancang khusus untuk menangani dataset skala besar dan ruang fitur berdimensi tinggi dengan efisien, sehingga menjadi pilihan ideal untuk berbagai tugas pembelajaran mesin, termasuk masalah regresi, klasifikasi, dan peringkat.

Fitur dan Keunggulan Unik LightGBM

LightGBM menawarkan beberapa fitur dan keunggulan utama dibandingkan dengan perpustakaan gradient boosting lainnya.

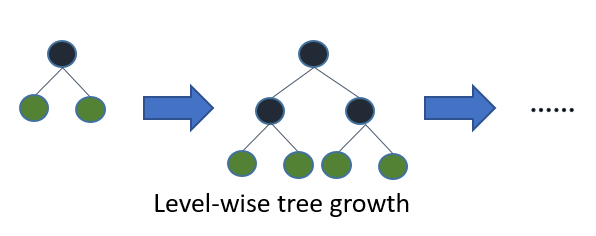

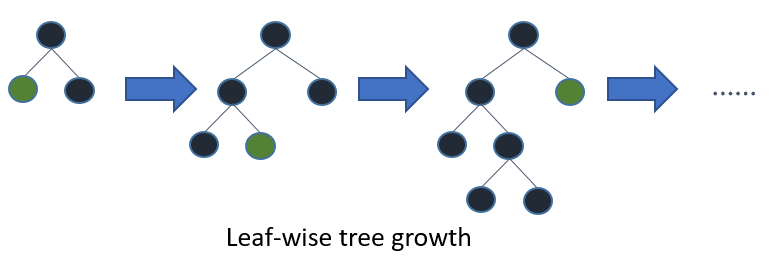

Pertumbuhan Pohon Leaf-wise

Algoritma gradient boosting tradisional menumbuhkan pohon secara level-wise, di mana semua simpul pada level yang sama dibagi sebelum simpul pada level berikutnya. Sebaliknya, LightGBM menggunakan strategi pertumbuhan leaf-wise, yang memprioritaskan pembagian simpul dengan penurunan kerugian tertinggi. Pendekatan ini memungkinkan konvergensi yang lebih cepat dan meningkatkan akurasi model, meskipun dengan risiko overfitting jika tidak dikendalikan dengan baik.

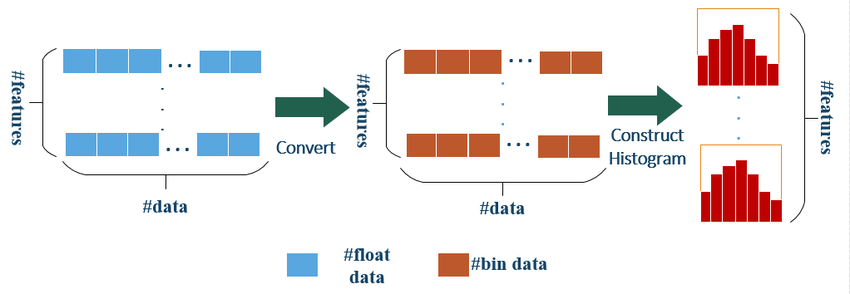

Algoritma Berbasis Histogram

LightGBM menggunakan algoritma berbasis histogram untuk mempercepat proses pelatihan. Ini memperkirakan nilai fitur yang kontinu dengan membaginya menjadi bin diskrit, yang mengurangi jumlah titik pembagi untuk dievaluasi. Pendekatan ini menghasilkan pengurangan waktu pelatihan dan penggunaan memori yang signifikan dibandingkan dengan metode gradient boosting tradisional.

Histogram algorithm of LightGBM

Dukungan Fitur Kategorikal

Berbeda dengan perpustakaan gradient boosting lainnya, LightGBM menawarkan dukungan native untuk fitur kategorikal, menghilangkan kebutuhan untuk one-hot encoding atau langkah preprocessing lainnya. Dengan menggunakan titik pembagi optimal, LightGBM dapat mengatasi variabel kategorikal dengan kardinalitas tinggi dengan efisien, yang meningkatkan kinerja model dan menyederhanakan proses rekayasa fitur.

Pembelajaran Paralel yang Efisien

LightGBM mendukung paralelisme data dan fitur, memungkinkan pembelajaran paralel yang efisien pada CPU multi-core dan sistem terdistribusi. Fitur ini memungkinkan LightGBM untuk beradaptasi dengan baik dengan dataset dan ruang fitur yang besar dan berdimensi tinggi, sehingga cocok untuk berbagai aplikasi.

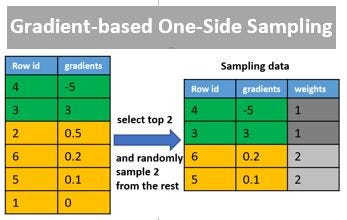

Gradient-based One-Side Sampling (GOSS)

Untuk lebih mempercepat proses pelatihan, LightGBM memperkenalkan Gradient-based One-Side Sampling (GOSS), teknik sampling baru. GOSS secara selektif mengambil sampel subset data pelatihan pada setiap iterasi berdasarkan besar gradien mereka. Instans dengan gradien yang lebih besar, yang memberikan kontribusi lebih banyak pada kerugian keseluruhan model, diprioritaskan, sementara subset acak instans dengan gradien yang lebih kecil juga disertakan untuk menjaga keberagaman data. Pendekatan ini mempertahankan sampel yang paling informatif sambil mengurangi biaya komputasi pelatihan, mengarah pada konvergensi yang lebih cepat dan peningkatan kinerja model.

An Example of Hyperparameter Optimization on XGBoost, LightGBM and CatBoost using Hyperopt

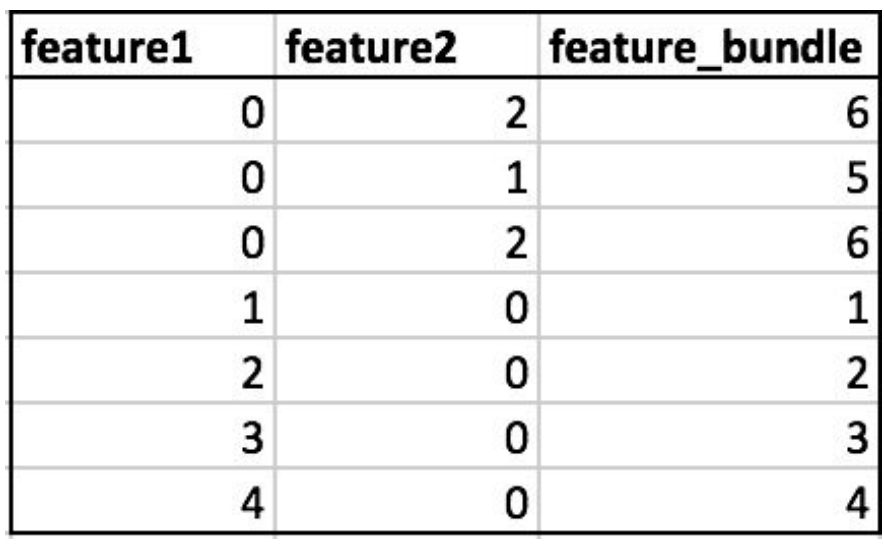

Exclusive Feature Bundling (EFB)

Fitur unik lain dari LightGBM adalah Exclusive Feature Bundling (EFB), yang bertujuan untuk mengurangi dimensionalitas dataset yang sparse. EFB mengidentifikasi set fitur saling eksklusif, yang berarti mereka tidak pernah mengambil nilai yang tidak sama secara bersamaan, dan menggabungkannya menjadi satu fitur. Proses penggabungan ini secara efektif mengompresi ruang fitur tanpa kehilangan informasi, memungkinkan konstruksi pohon yang lebih efisien dan penggunaan memori yang lebih rendah. EFB sangat berguna ketika berurusan dengan dataset sparse berdimensi tinggi yang biasa ditemukan dalam tugas prediksi teks dan klik.

Comparing lightgbm to other R GBDT libraries

Perbandingan dengan XGBoost

Baik XGBoost maupun LightGBM dirancang untuk memberikan kinerja dan skalabilitas yang tinggi untuk dataset skala besar. Namun, LightGBM sering kali lebih unggul dari XGBoost dalam hal kecepatan pelatihan dan penggunaan memori, berkat algoritma berbasis histogram, pertumbuhan pohon leaf-wise, GOSS, dan EFB. Fitur-fitur ini memungkinkan LightGBM untuk mengatasi dataset yang lebih besar dan ruang fitur yang berdimensi lebih tinggi dengan lebih efisien daripada XGBoost.

Namun, penting untuk dicatat bahwa kinerja dapat bervariasi tergantung pada masalah dan dataset tertentu. Dalam beberapa kasus, XGBoost mungkin memberikan akurasi yang lebih baik, sedangkan LightGBM mungkin memberikan waktu pelatihan yang lebih cepat. Disarankan untuk mencoba kedua perpustakaan pada dataset Anda untuk menentukan mana yang menawarkan kinerja terbaik untuk kasus tertentu Anda.

Kemudahan Penggunaan

Baik XGBoost maupun LightGBM menawarkan antarmuka yang mudah digunakan dan dapat dengan mudah diintegrasikan dengan perpustakaan pembelajaran mesin populer seperti scikit-learn, Keras, dan TensorFlow. Kedua perpustakaan menyediakan dokumentasi lengkap dan dukungan komunitas aktif, sehingga mudah diakses oleh pengguna dari semua tingkat pengalaman.

Fitur Unik

Meskipun kedua perpustakaan memiliki banyak fitur yang sama, mereka juga memiliki kemampuan unik yang membedakan satu sama lain. Beberapa fitur unik utama dari LightGBM termasuk:

- Pertumbuhan pohon leaf-wise

- Gradient-based One-Side Sampling (GOSS)

- Exclusive Feature Bundling (EFB)

- Dukungan native untuk fitur kategorikal

Di sisi lain, XGBoost menawarkan fitur unik berikut:

- Column block untuk memori eksternal

- Dukungan bawaan untuk nilai yang hilang

- Objektif pembelajaran teratur

- Batasan monoton pada pembagian pohon

Referensi